AIの大規模活用の壁を打ち破る

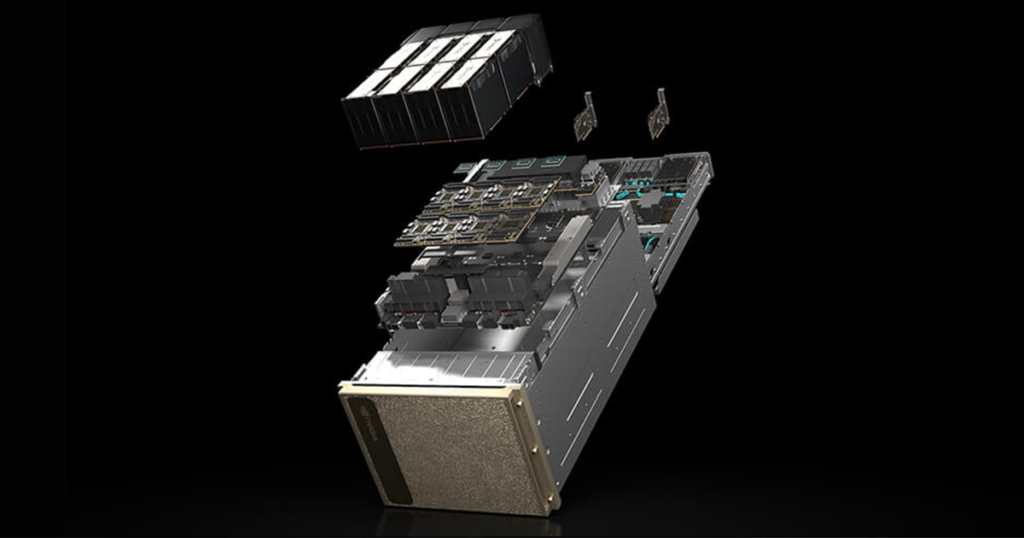

NVIDIA DGX H100は世界で初めてNVIDIA H100 Tensor コア GPUを搭載したシステムであり、AIの規模とパフォーマンスの限界を突破します。

NVIDIA DGX H100は、AI研究開発、データ解析、機械学習モデルのトレーニングなど、さまざまな用途に最適です。特に、自然言語処理やディープラーニングによるレコメンデーションモデルなど、大規模なワークロードに対応するために設計されています。

NVIDIA DGX H100 はすべてを最適化したハードウェアとソフトウェアのプラットフォームに、新しい各種 NVIDIA AI ソフトウェア ソリューションのフルサポート、充実したサードパーティ サポート エコシステム、NVIDIA プロフェッショナル サービスからの専門的なアドバイスが含まれています。

DGX プラットフォームは、世界のほぼすべての業界で何千社もの企業が利用しており、NVIDIA DGX H100 には立証された信頼性があります。

NVIDIA DGX H100 特長

圧倒的なパフォーマンス

8基のNVIDIA H100 Tensor コア GPUを搭載し、合計640GBのGPUメモリ。

前世代比で6倍の高速化を実現

高いスケーラビリティ

900GB/秒の双方向帯域幅を持つNVIDIA NVLinkとNVIDIA NVSwitchにより、スムーズなデータ転送を実現

強力なネットワーキング

400Gb/秒のネットワークインターフェイスを2基搭載し、ピーク時の双方向ネットワーク帯域幅は1TB/秒

大容量ストレージ

30TBのNVMe SSDにより、最高のパフォーマンスを実現するための高速ストレージ

NVIDIA DGX H100 スペック

※ 仕様は変更になる場合があります。

| NVIDIA DGX H100 | |

| 搭載GPU | NVIDIA H100 Tensor コアGPU[80GB] × 8基 |

| GPUメモリ | 合計 640GB |

| 演算性能 | 32peta FLOPS FP8 |

| NVIDIA® NVSwitch™ | × 4 |

| CPU | Intel® Xeon® Platinum 8480C プロセッサ × 2 合計 112コア 2.0GHz(ベース)、3.8GHz(最大ブースト) |

| システムメモリ | 最大 2TB |

| ネットワーキング | 4 個のOSFP ポートで 8 個のシングルポートを提供する NVIDIA ConnectX-7 VPI >最大 400Gb/秒の InfiniBand/Ethernet 2 個のデュアルポート QSFP112 NVIDIA ConnectX-7 VPI >最大 400Gb/秒の InfiniBand/Ethernet |

| ストレージ | OS: 2 個の 1.9TB NVMe M.2 内部ストレージ: 8 個の 3.84TB NVMe U.2 |

| システムソフトウェア | ・NVIDIA AI Enterprise – 最適化された AI ソフトウェア ・NVIDIA Base Command™ – オーケストレーション、スケジューリング、クラスター管理 ・DGX OS / Ubuntu – オペレーティング システム |

| システムサイズ | 高さ 356mm × 幅 482.2mm × 長さ 897.1mm、130.45kg |

| 運用温度範囲 | 5 - 30°C |

| 最大消費電力 | 最大 10.2kW |

| 企業向けサポート | ・ハードウェアとソフトウェアの 3 年間のエンタープライズ Business-Standard サポート ・年中無休のエンタープライズ サポート ポータル アクセス ・営業時間中のライブ エージェント サポート |

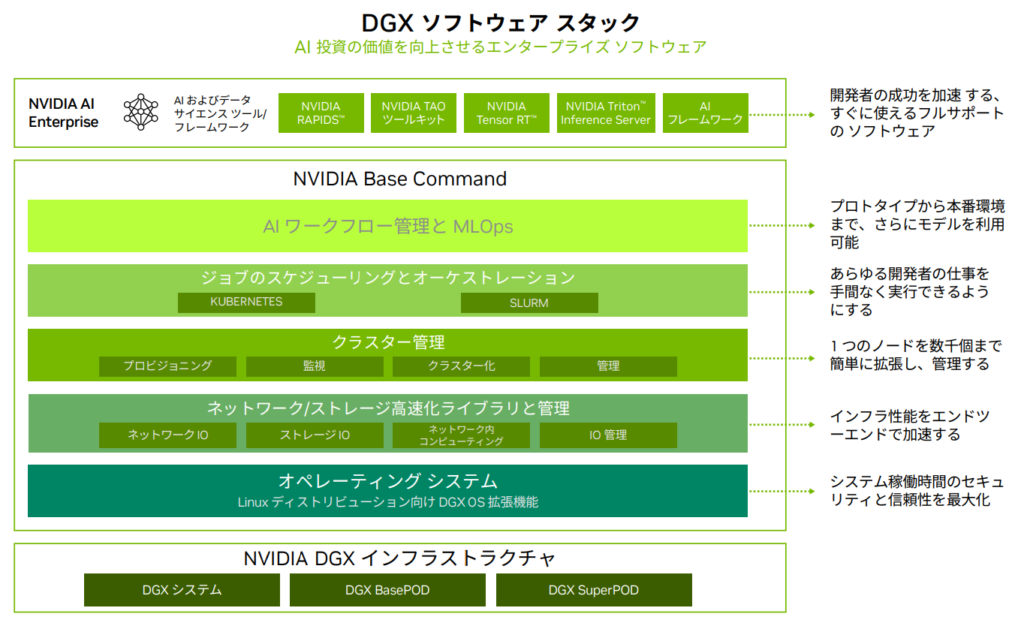

NVIDIA DGX プラットフォーム

実証済みインフラ標準

NVIDIA DGX H100の完全統合型ソリューションは、AIの開発から導入までの全プロセスを一元管理するために設計されています。このソリューションは、ハードウェアとソフトウェアが緊密に統合されており、NVIDIA Base Command™やNVIDIA AI Enterpriseソフトウェアスイートを含んでいます。

これにより、ユーザーは複雑なAIワークロードを効率的に管理し、迅速に成果を出すことができます。

NVIDIA Base Command 搭載

NVIDIA Base Commandは DGX プラットフォームを強化し、NVIDIA ソフトウェアがもたらすイノベーションを企業が最大級活用できるようにします。

企業は、エンタープライズグレードのオーケストレーションとクラスター管理、コンピューティング、ストレージ、ネットワークのインフラを高速化するライブラリ、AI ワークロード向けに最適化されたオペレーティング システムを含む実証済みのプラットフォームで、DGX インフラの可能性を最大限まで引き出すことができます。

また、DGX インフラには、AI の開発と展開を効率化するために最適化された一連のソフトウェア、NVIDIA AI Enterprise も含まれています。